Mathematik-Online-Lexikon:

|

[Home] [Lexikon] [Aufgaben] [Tests] [Kurse] [Begleitmaterial] [Hinweise] [Mitwirkende] [Publikationen] |

|

Mathematik-Online-Lexikon: | |

Konjugierte Gradienten von Fletcher und Reves |

| A B C D E F G H I J K L M N O P Q R S T U V W X Y Z | Übersicht |

Das Verfahren der konjugierten Gradienten bestimmt

bei exakter Rechnung das Minimum einer quadratischen

konvexen Funktion

von ![]() Variablen in höchstens

Variablen in höchstens ![]() Schritten.

Fletcher und Reves formulierten den Algorithmus so,

dass er auf beliebige

glatte Funktionen

Schritten.

Fletcher und Reves formulierten den Algorithmus so,

dass er auf beliebige

glatte Funktionen ![]() angewendet werden kann.

angewendet werden kann.

Ausgehend von Startwerten

Der einzige Unterschied zum quadratischen Fall ist,

dass

![]() nicht explizit bestimmt werden

kann.

nicht explizit bestimmt werden

kann.

Ein gute Performance kann besonders dann erzielt

werden, wenn ![]() gut durch eine quadratische

konvexe Funktion approximiert wird.

Ist dies nicht der Fall, so sollte in geeigneten

Abständen ein Neustart des Verfahrens erfolgen.

gut durch eine quadratische

konvexe Funktion approximiert wird.

Ist dies nicht der Fall, so sollte in geeigneten

Abständen ein Neustart des Verfahrens erfolgen.

Die eindimensionale Minimierung wird im allgemeinen nicht exakt durchgeführt. Dann ist jedoch darauf zu achten, dass

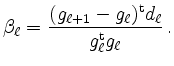

Es existieren einige Varianten bei der Parameterwahl, die ebenfalls mit dem quadratischen Fall konsistent sind. Beispielsweise definieren Polak und Ribiere

| automatisch erstellt am 19. 8. 2013 |