Mathematik-Online-Kurs: Lineare Algebra - Grundlegende Strukturen - Basen

|

[Home] [Lexikon] [Aufgaben] [Tests] [Kurse] [Begleitmaterial] [Hinweise] [Mitwirkende] [Publikationen] |

|

|

Mathematik-Online-Kurs: Lineare Algebra - Grundlegende Strukturen - Basen | ||

Lineare Unabhängigkeit | ||

| [vorangehende Seite] [nachfolgende Seite] | [Gesamtverzeichnis][Seitenübersicht] |

Vektoren

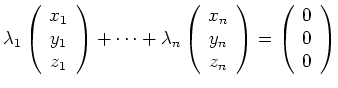

![]() heißen linear abhängig, wenn es

Skalare

heißen linear abhängig, wenn es

Skalare

![]() gibt mit

gibt mit

Allgemeiner bezeichnet man eine Menge ![]() von Vektoren als linear unabhängig, wenn

jede endliche Teilmenge von

von Vektoren als linear unabhängig, wenn

jede endliche Teilmenge von ![]() aus linear unabhängigen Vektoren besteht.

Andernfalls heißt

aus linear unabhängigen Vektoren besteht.

Andernfalls heißt ![]() linear abhängig.

linear abhängig.

|

liefert

| ||

|

bzw.

| ||

Drei Vektoren ![]() im

im

![]() sind immer linear abhängig, denn der

Ansatz

sind immer linear abhängig, denn der

Ansatz

|

führt auf ein unterbestimmtes, homogenes lineares Gleichungssystem

| ||

Drei Vektoren sind linear abhängig, wenn zwei Vektoren parallel sind oder wenn ein Vektor in der von den beiden anderen Vektoren aufgespannten Ebene liegt. Beispielsweise gilt für

Definitionsgemäß ist der Test für lineare Abhängigkeit äquivalent zu einem homogenen linearen Gleichungssystem

| [vorangehende Seite] [nachfolgende Seite] | [Gesamtverzeichnis][Seitenübersicht] |

| automatisch erstellt am 14.6.2012 |