Mathematik-Online-Kurs: Differentialrechnung mehrerer Veränderlicher - Ableitungsregeln

|

[Home] [Lexikon] [Aufgaben] [Tests] [Kurse] [Begleitmaterial] [Hinweise] [Mitwirkende] [Publikationen] |

|

Mathematik-Online-Kurs: Differentialrechnung mehrerer Veränderlicher - Ableitungsregeln | |

Methode des steilsten Abstiegs |

| [vorangehende Seite] [nachfolgende Seite] | [Gesamtverzeichnis][Seitenübersicht] |

Die Methode des steilsten Abstiegs dient zur

Minimierung multivariater Funktionen

![]() .

Zur Durchführung eines Iterationsschrittes

.

Zur Durchführung eines Iterationsschrittes

![]() wird zunächst der negative Gradient

wird zunächst der negative Gradient

![\includegraphics[width=0.55\linewidth]{Bild_Steilster_Abstieg_Aussage}](/inhalt/aussage/aussage1499/img8.png)

Wie in der Abbildung illustriert, ist die

Suchrichtung orthogonal zu der Niveaumenge durch

![]() und berührt eine Niveaumenge zu einem kleineren

Funktionswert in

und berührt eine Niveaumenge zu einem kleineren

Funktionswert in ![]() .

.

Die Konvergenz der durch die Methode des steilsten

Abstiegs erzeugten Folge

![]() kann unter

sehr allgemeinen Voraussetzungen gezeigt werden.

Hinreichend ist, dass

kann unter

sehr allgemeinen Voraussetzungen gezeigt werden.

Hinreichend ist, dass ![]() nach unten beschränkt ist

und

nach unten beschränkt ist

und

![]() in einer Umgebung

in einer Umgebung ![]() der Menge

der Menge

![]() Lipschitz-stetig ist, d.h.

Lipschitz-stetig ist, d.h.

Dies impliziert insbesondere, dass jeder Häufungspunkt der Folge

![]() ein kritischer Punkt von

ein kritischer Punkt von ![]() ist.

Dass es sich um ein lokales Minimum handelt

ist statistisch gesehen fast sicher, kann jedoch

nicht zwingend gefolgert werden.

ist.

Dass es sich um ein lokales Minimum handelt

ist statistisch gesehen fast sicher, kann jedoch

nicht zwingend gefolgert werden.

In dem Algorithmus braucht die eindimensionale

Minimierung nur näherungsweise durchgeführt

werden.

Die Suchrichtung ![]() muss nicht als der negative

Gradient gewählt, und eine globale Minimalstelle

muss nicht als der negative

Gradient gewählt, und eine globale Minimalstelle

![]() nicht bestimmt werden.

Entscheidend für die Konvergenz ist lediglich,

dass in jedem Iterationsschritt eine Reduktion

des Funktionswertes proportional zu

nicht bestimmt werden.

Entscheidend für die Konvergenz ist lediglich,

dass in jedem Iterationsschritt eine Reduktion

des Funktionswertes proportional zu

![]() erreicht wird.

erreicht wird.

Download:

| (Dateityp: .m, | 312 , | 22.06.2016) |

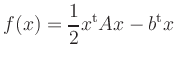

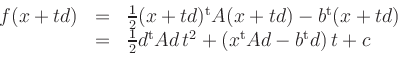

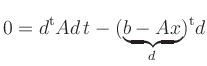

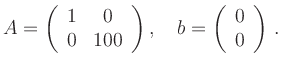

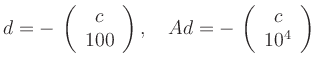

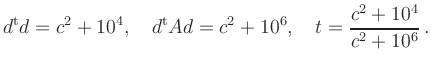

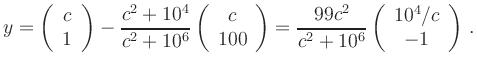

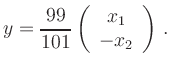

Für eine quadratische Funktion

Wie die Abbildung zeigt, kann es zu unerwünschten

Oszillationen kommen, wenn ![]() Eigenwerte stark

unterschiedlicher Größenordnung besitzt.

Ein extremes Beispiel erhält man für

Eigenwerte stark

unterschiedlicher Größenordnung besitzt.

Ein extremes Beispiel erhält man für

| [vorangehende Seite] [nachfolgende Seite] | [Gesamtverzeichnis][Seitenübersicht] |

| automatisch erstellt am 5.1.2017 |