Mathematik-Online:

|

[Home] [Lexikon] [Aufgaben] [Tests] [Kurse] [Begleitmaterial] [Hinweise] [Mitwirkende] [Publikationen] |

|

Mathematik-Online: | |

Hermitesch, unitär, normal |

| A B C D E F G H I J K L M N O P Q R S T U V W X Y Z | Übersicht |

Begriffe.

Sei ![]() , sei

, sei

![]() . Schreiben wir

. Schreiben wir

![]() , so sei

, so sei

![]() .

.

Ist ![]() unitär, so ist

unitär, so ist ![]() normal. Ist

normal. Ist ![]() hermitesch, so ist

hermitesch, so ist ![]() normal.

normal.

Es ist ![]() unitär genau dann, wenn die Spalten von

unitär genau dann, wenn die Spalten von ![]() eine Orthonormalbasis von

eine Orthonormalbasis von

![]() bilden.

bilden.

Es ist ![]() hermitesch genau dann, wenn die Einträge an den bezüglich der Hauptdiagonalen gespiegelten Positionen bis auf Konjugation

übereinstimmen. Insbesondere, ist

hermitesch genau dann, wenn die Einträge an den bezüglich der Hauptdiagonalen gespiegelten Positionen bis auf Konjugation

übereinstimmen. Insbesondere, ist ![]() hermitesch, so hat

hermitesch, so hat ![]() auf der Diagonalen reelle Einträge.

auf der Diagonalen reelle Einträge.

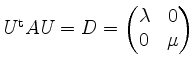

Es heißt ![]() unitär diagonalisierbar, wenn es eine unitäre Matrix

unitär diagonalisierbar, wenn es eine unitäre Matrix

![]() gibt mit

gibt mit

![]() diagonal.

diagonal.

Ist ![]() unitär diagonalisierbar, so ist

unitär diagonalisierbar, so ist ![]() insbesondere diagonalisierbar.

insbesondere diagonalisierbar.

Der Beweis von ersterer Aussage benötigt die folgenden beiden Aussagen, die auch für sich genommen von Interesse sein können.

Unitäres Diagonalisieren.

Sei

![]() normal. Um eine unitäre Matrix

normal. Um eine unitäre Matrix

![]() so zu finden, daß

so zu finden, daß

![]() diagonal ist, verfahren wir wie folgt.

diagonal ist, verfahren wir wie folgt.

Zur Probe verifizieren wir ![]() sowie

sowie ![]() unitär. Insbesondere ist es eine oft aufschlußreiche Probe, zu verifizieren, daß Eigenvektoren

verschiedener Eigenräume zueinander orthogonal sind; dies ist bei normalen Matrizen nämlich stets der Fall.

unitär. Insbesondere ist es eine oft aufschlußreiche Probe, zu verifizieren, daß Eigenvektoren

verschiedener Eigenräume zueinander orthogonal sind; dies ist bei normalen Matrizen nämlich stets der Fall.

Definitheit.

Sei

![]() . Sei

. Sei

![]() ,

,

![]() die zu

die zu ![]() gehörige quadratische Form.

gehörige quadratische Form.

Sei nun ![]() hermitesch.

hermitesch.

Kurz, ![]() ist negativ (semi-)definit genau dann, wenn

ist negativ (semi-)definit genau dann, wenn ![]() positiv (semi-)definit ist.

Und es ist

positiv (semi-)definit ist.

Und es ist ![]() indefinit genau dann, wenn

indefinit genau dann, wenn ![]() weder positiv semidefinit noch negativ

semidefinit ist.

weder positiv semidefinit noch negativ

semidefinit ist.

Anwendung der Definition auf die Standardbasisvektoren ![]() zeigt, daß eine positiv definite Matrix positive Hauptdiagonaleinträge, und eine

negativ definite Matrix negative Hauptdiagonaleinträge aufweist.

zeigt, daß eine positiv definite Matrix positive Hauptdiagonaleinträge, und eine

negativ definite Matrix negative Hauptdiagonaleinträge aufweist.

Aber Vorsicht, es ist z.B.

trotz positiver Hauptdiagonaleinträge nicht positiv definit, sondern vielmehr indefinit (warum?).

trotz positiver Hauptdiagonaleinträge nicht positiv definit, sondern vielmehr indefinit (warum?).

Umgekehrt aber, gibt es einen positiven und einen negativen Hauptdiagonaleintrag in ![]() , so ist

, so ist ![]() indefinit.

indefinit.

Wir erinnern daran, daß eine hermitesche Matrix ausschließlich reelle Eigenwerte besitzt.

Das folgende Eigenwertkriterium kann alle Fälle unterscheiden.

Stehen die Eigenwerte nicht zur Verfügung, so kann man stattdessen das charakteristische Polynom

![]() heranziehen.

heranziehen.

Sei

![]() . Schreiben wir

. Schreiben wir

![]() , so sei

, so sei

die

Das folgende Hauptminorenkriterium erkennt nur Definitheit, nicht Semidefinitheit.

Das Hauptminorenkriterium für die negative Definitheit besagt also, daß die Vorzeichen der Hauptminoren alternieren, angefangen mit einem negativen Vorzeichen.

Signatur.

Sei

![]() die Anzahl der positiven Eigenwerte von

die Anzahl der positiven Eigenwerte von ![]() , sei

, sei

![]() die Anzahl der negativen Eigenwerte von

die Anzahl der negativen Eigenwerte von ![]() , jeweils gezählt

mit algebraischer Vielfachheit. Unter der Signatur von

, jeweils gezählt

mit algebraischer Vielfachheit. Unter der Signatur von ![]() versteht man das Paar

versteht man das Paar

![]() .

.

Die hermitesche Matrix

![]() ist positiv definit genau dann, wenn ihre Signatur gleich

ist positiv definit genau dann, wenn ihre Signatur gleich ![]() ist; sie ist positiv semidefinit genau dann,

wenn ihre Signatur von der Form

ist; sie ist positiv semidefinit genau dann,

wenn ihre Signatur von der Form ![]() ist mit

ist mit

![]() ; sie ist negativ definit genau dann, wenn ihre Signatur gleich

; sie ist negativ definit genau dann, wenn ihre Signatur gleich ![]() ist; sie ist negativ

semidefinit genau dann, wenn ihre Signatur von der Form

ist; sie ist negativ

semidefinit genau dann, wenn ihre Signatur von der Form ![]() ist mit

ist mit

![]() ; sie ist indefinit, wenn ihre Signatur von der Form

; sie ist indefinit, wenn ihre Signatur von der Form

![]() ist mit

ist mit

![]() .

.

Sei

![]() . Der Sylvestersche Trägheitssatz besagt, daß

. Der Sylvestersche Trägheitssatz besagt, daß ![]() und

und

![]() dieselbe Signatur haben. Dies ermöglicht es uns,

die Signatur von

dieselbe Signatur haben. Dies ermöglicht es uns,

die Signatur von ![]() mit folgendem beidseitigen Gaußalgorithmus zu berechnen.

mit folgendem beidseitigen Gaußalgorithmus zu berechnen.

Zunächst formen wir mit folgenden Schritten ![]() um zu einer Matrix der Gestalt

um zu einer Matrix der Gestalt

, mit

, mit

![]() und

und

![]() .

.

Diese Prozedur führe man nun erneut für die hermitesche Matrix ![]() durch, usf. Die schließlich resultierende Diagonalmatrix hat dieselbe Signatur wie

durch, usf. Die schließlich resultierende Diagonalmatrix hat dieselbe Signatur wie ![]() .

.

Quadriken in

![]() .

.

Hermitesche Matrizen mit reellen Einträgen heißen auch symmetrisch.

Unitäre Matrizen mit reellen Einträgen heißen auch orthogonal.

Wir bemerken hier, daß eine symmetrische Matrix ![]() auch orthogonal diagonalisierbar ist, d.h. es gibt eine orthogonale Matrix

auch orthogonal diagonalisierbar ist, d.h. es gibt eine orthogonale Matrix ![]() so, daß

so, daß

![]() .

.

Sei

symmetrisch.

symmetrisch.

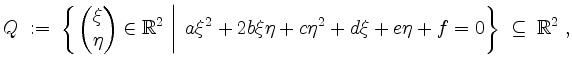

Seien ferner

![]() beliebig. Wir betrachten die Quadrik

beliebig. Wir betrachten die Quadrik

definiert durch die Gleichung

welche wir vereinfachen wollen.

Das folgende Verfahren liefert die Gestalt der Quadrik ![]() ; einen Mittelpunkt oder einen Scheitelpunkt von

; einen Mittelpunkt oder einen Scheitelpunkt von ![]() ; eine orthogonale Matrix, deren

Spalten die Hauptachsen von

; eine orthogonale Matrix, deren

Spalten die Hauptachsen von ![]() sind; sowie gegebenenfalls die Halbachsen von

sind; sowie gegebenenfalls die Halbachsen von ![]() .

.

Diagonalgestalt hat.

Die Spalten von

Diagonalgestalt hat.

Die Spalten von

für

für

mit

Im Falle ![]() substituiere man

substituiere man

![]() für

für ![]() mit

mit

![]() .

.

Durch diese quadratische Ergänzung wird die Gleichung überführt in

mit gewissen

und substituiere

und substituiere

Im Falle ![]() setze man, falls

setze man, falls ![]() ist,

ist,

und substituiere

und substituiere

![]() für

für ![]() . Auch hier verschwindet der konstante Term.

. Auch hier verschwindet der konstante Term.

Durch diese linearen Substitutionen wird die Gleichung überführt in

mit gewissen

und den Halbachsen

und den Halbachsen

, Halbachse

, Halbachse  ).

).

Zur Illustration diene die Ellipse mit der Gleichung

![]() .

.

![\includegraphics[width = 15cm,height = 15cm]{ellipse.eps}](/inhalt/vstatisch/vstatisch55/img125.png)

Reguläre Quadriken in

![]() .

.

Sei ![]() und sei

und sei

![]() eine reguläre symmetrische Matrix. Sei

eine reguläre symmetrische Matrix. Sei

![]() und sei

und sei

![]() .

.

Wir betrachten die Quadrik

definiert durch die Gleichung

welche wir vereinfachen wollen. Wegen

Das folgende Verfahren liefert den Mittelpunkt von ![]() ; eine orthogonale Matrix, deren Spalten die Hauptachsen von

; eine orthogonale Matrix, deren Spalten die Hauptachsen von ![]() sind;

die Form und gegebenenfalls die Halbachsen von

sind;

die Form und gegebenenfalls die Halbachsen von ![]() .

.

wobei

mit

Hat

Ein ![]() -Ellipso-0

-hyperboloid heißt auch einfach Ellipsoid. Ein 0

-Ellipso-

-Ellipso-0

-hyperboloid heißt auch einfach Ellipsoid. Ein 0

-Ellipso-![]() -hyperboloid ist die leere Menge.

-hyperboloid ist die leere Menge.

Ist

![]() , so nennt man

, so nennt man

![]() auch eine Halbachse von

auch eine Halbachse von ![]() .

.

Im Falle ![]() ist ein

ist ein ![]() -Ellipso-0

-hyperboloid einfach einer Ellipse, und

ein

-Ellipso-0

-hyperboloid einfach einer Ellipse, und

ein ![]() -Ellipso-

-Ellipso-![]() -hyperboloid einfach eine Hyperbel.

-hyperboloid einfach eine Hyperbel.

Im Falle ![]() spricht man statt von einem

spricht man statt von einem ![]() -Ellipso-

-Ellipso-![]() -hyperboloid auch von einem einschaligen Hyperboloid und statt von einem

-hyperboloid auch von einem einschaligen Hyperboloid und statt von einem

![]() -Ellipso-

-Ellipso-![]() -hyperboloid auch von einem zweischaligen Hyperboloid.

-hyperboloid auch von einem zweischaligen Hyperboloid.

Beispiele:

| automatisch erstellt am 22. 8. 2006 |