Mathematik-Online-Kurs: Repetitorium HM III - Wahrscheinlichkeitsrechnung und Statistik

|

[Home] [Lexikon] [Aufgaben] [Tests] [Kurse] [Begleitmaterial] [Hinweise] [Mitwirkende] [Publikationen] |

|

Mathematik-Online-Kurs: Repetitorium HM III - Wahrscheinlichkeitsrechnung und Statistik | |

Zufallsvariable und Erwartungswert |

| [vorangehende Seite] [nachfolgende Seite] | [Gesamtverzeichnis][Seitenübersicht] |

Zufallsvariablen sind von den Elementarereignissen abhängige Meßgrößen, über die wahrscheinlichkeitstheoretische Aussagen getroffen werden sollen. So z.B. kann man sich fragen, welche Meßgröße im Mittel erwartet werden kann.

Eine Zufallsvariable

![]() ist eine Funktion

ist eine Funktion

![]() ,

für die

,

für die

![]() ein meßbares Ereignis ist für

alle

ein meßbares Ereignis ist für

alle

![]() . Die

Wahrscheinlichkeit

. Die

Wahrscheinlichkeit

![]() dieses Ereignisses in Abhängigkeit von

dieses Ereignisses in Abhängigkeit von

![]() heißt auch Verteilungsfunktion

von

heißt auch Verteilungsfunktion

von

![]() .

.

Für

![]() schreiben wir auch

schreiben wir auch

![]() ,

,

![]() etc.

etc.

Sei

![]() eine Indexmenge. Die

Zufallsvariablen

eine Indexmenge. Die

Zufallsvariablen

![]() für

für

![]() heißen unabhängig, falls die Ereignisse

heißen unabhängig, falls die Ereignisse

![]() unabhängig sind für alle endlichen Indextupel

unabhängig sind für alle endlichen Indextupel

![]() und je alle

und je alle

![]() ,

,

![]() .

.

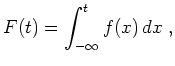

Existiert eine integrierbare Funktion

![]() mit

mit

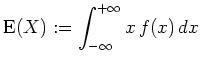

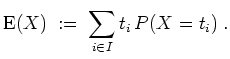

Der Erwartungswert von

![]() ist dann definiert als

ist dann definiert als

Ist

![]() diskret verteilt, d.h.

diskret verteilt, d.h.

![]() ,

setzen wir analog

,

setzen wir analog

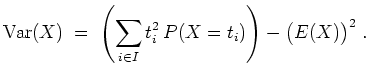

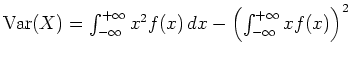

Die Varianz

![]() , mit der die zu erwartende Abweichung vom

Erwartungswert gemessen werden soll, ist definiert als

, mit der die zu erwartende Abweichung vom

Erwartungswert gemessen werden soll, ist definiert als

Im diskreten Fall ergibt sich also

Es gelten für Zufallsvariablen

![]() und

und

![]() die folgenden Regeln.

die folgenden Regeln.

.

.

| automatisch erstellt am 21.3.2003 |